Testy A/B kiedy warto je przeprowadzać?

W życiu wybory często są trudne. Na przykład wtedy gdy poznajesz siostry bliźniaczki, a ponieważ sprawiedliwość nie istnieje. to musisz wybrać pomiędzy jedną a drugą.

Problem jest taki, że obie posiadają ten sam uśmiech, spojrzenie, są fajne z charakteru. Powstaje więc dylemat, z którym musisz się uporać.

Na szczęście jest jedna różnica pomiędzy nimi - kolor włosów, jedna to brunetka a druga blondynka. Skoro nie masz możliwości stworzenia haremu, wybierasz jedną z nich na tej podstawie.

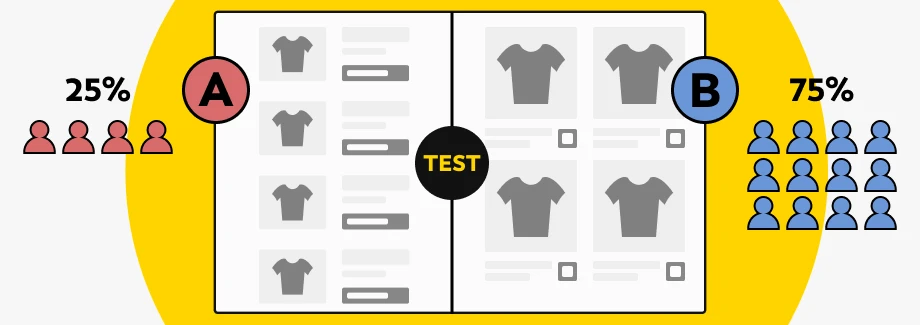

To w skrócie jest przedstawienie testu A/B na stronie internetowej. Zmieniasz jedną rzecz i pokazujesz losowo odwiedzającym stronę raz ze zmianą raz oryginalną.

Testy A/B co to?

Test A/B to metoda badawcza polegająca na porównaniu dwóch wersji strony (aplikacji, e-maila…), aby sprawdzić, która bardziej realizuje cel: więcej kliknięć, więcej zapisów, mniej porzuceń koszyka.

Wersja A = Twoja obecna wersja

Wersja B = wersja z jedną zmianą

Wikipedia ma tu akapit, ale nie będę go cytować - bo Wikipedia nie płaci mi za SEO.

Kiedy warto przeprowadzić testy A/B?

Strona działa, więc nic tylko testować. Prawda? Niezupełnie, testy A/B nie zawsze mają sens i warto je przeprowadzać kiedy na stronie istnieje już jakiś ruch… Kluczowe w tym wypadku jest słowo “jakiś”.

Pozwól, że przeprowadzę Cię przez okres studiów, na których ze względu na profil często pojawiała się matematyka jako królowa nauk. A jedną z części, które musieliśmy się nauczyć była statystyka. W statystyce bada się właśnie różne zależności i oblicza prawdopodobieństwa.

Prawdopodobieństwo to z kolei informacja, która mówi jak duże szanse na wystąpienie ma badana sytuacja. I tak oto otrzymujemy statystyczne szanse, szanse jednak podważane są przez inną miarę, która nazywa się “błędem statystycznym”.

Błąd statystyczny mówi jak duża jest szansa na to, że te wyliczone prawdopodobieństwo jest g… warte.

Tak oto dochodzimy do sedna sprawy, czy można mierzyć przy niskim ruchu (nie, żeby ktoś mógł Ci tego zabronić tak czy owak) to odpowiedź brzmi tak można. A czy warto?

Tutaj posiłkując się opowieścią można z wielką śmiałością powiedzieć… To zależy, ale zazwyczaj nie warto.

Także testy A/B warto przeprowadzić przy kilku warunkach jakie są spełnione, czyli:

- Masz już skończoną stronę

W innym wypadku ciężko jest podjąć decyzję co chcesz testować, może to być nowy układ. - Masz hipotezę

Założenie, które chcesz sprawdzić i może to być np. nowy kolor przycisku. oparte nie na słowach “wydaje mi się”. - Masz cel, który chcesz mierzyć

I tutaj trzeba uważać, ponieważ zwykłe “czy zarobimy więcej na większej ilości reklam” może okazać się dobrym celem na przełomie kilku miesięcy, po czym ilość reklam, która zaszkodzi UX spowoduje inny efekt. - Masz czas na testowanie

Aby dobrze przeprowadzić test musi on jakiś czas potrwać i często nie jest to kwestia jednego lub dwóch tygodni tylko miesięcy, po których dopiero będzie wiadomo czy zmiana wprowadzona ma sens. W tym czasie ciężko jest zmierzyć cokolwiek innego na tej samej stronie.

Testy a/b marketing.

Na stronach internetowych możesz przeprowadzić testy praktycznie wszystkiego, zaczynając od zwykłej zmiany koloru bądź treści na przycisku kończąc na całym layoucie. Najczęściej testowane elementy (te na stronach i poza nimi) to:

- CTA (Call to Action)

Najmniejszy, a najpotężniejszy element. Testuj tekst, kolor, wielkość, umiejscowienie i liczbę CTA na stronie. - Nagłówki

Decydują, czy użytkownik zostanie czy ucieknie. Testuj ton, długość, jasność komunikatu i obietnicę wartości. - Układ strony (layout)

Sama zmiana kolejności sekcji potrafi zwiększyć lub zabić konwersję. Testuj strukturę, długość i widoczność kluczowych elementów. - Treści (copy)

Styl, długość, konkrety, storytelling – wszystko wpływa na decyzję użytkownika. Testuj różne formy przekazu. - Formularze

Najczęstszy punkt porzuceń. Testuj liczbę pól, układ, komunikaty błędów, walidację i CTA w formularzu. - Mailing

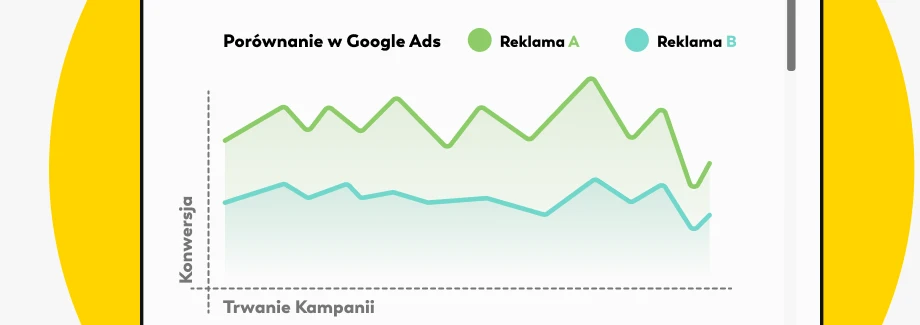

Idealne pole testowe. Testuj tytuły, preheader (to co przed tytułem), długość wiadomości, CTA i format maila. - Reklamy

Płacisz za każdy błąd, więc testuj wszystko: nagłówki, opisy, grafiki, wideo, grupy odbiorców i strony docelowe. - Koszyk i checkout

Tu zarabiasz lub tracisz. Testuj liczbę kroków, komunikaty o dostawie, prezentację płatności i koszty dostawy. - Hero section

Pierwsze 3 sekundy decydują o wszystkim. Testuj nagłówek, podnagłówek, CTA, grafikę i układ.

Częste pułapki i błędy przy testach A/B, na które trzeba uważać.

Zanim zaczniesz czytać o sukcesach testów gdzie coś zwiększone zostało o miliard procent (wstaw tu dowolną metrykę) warto przyjrzeć się elementom, na które trzeba zwrócić uwagę. Bardzo fajnie opisała je Anika Jahin w swojej publikacji:

- Brak jasnego celu i hipotezy

Pułapka: Uruchamiasz test A/B „bo wypada”, ale bez hipotezy i bez konkretnego pytania badawczego.

Dlaczego to problem: Jeśli nie wiesz, co właściwie testujesz, to Twój wynik będzie o wszystkim i o niczym — czyli o niczym. Możesz badać zmienne kompletnie niezwiązane z Twoimi celami biznesowymi.

Jak tego uniknąć:

Zawsze zaczynaj od hipotezy:

„Jeśli zmienimy X, to Y ulegnie poprawie, ponieważ Z.”

Przykład: „Czy zmiana koloru przycisku zwiększy konwersję?”

Zdefiniuj jeden wskaźnik sukcesu i trzymaj się go. - Za mała (lub za duża) próba

Pułapka: Testujesz na 50 użytkownikach, bo akurat tyle weszło w poniedziałek. Albo odwrotnie ciągniesz test miesiącami dla „pełnej pewności”.

Dlaczego to problem: Za mała próba = wyniki jak z wróżenia z kart. Za duża = marnujesz czas i kasę, bo wynik mógł być znany dużo wcześniej.

Jak tego uniknąć:

Używaj kalkulatorów wielkości próby (mają je wszystkie normalne narzędzia do A/B testów). Załóż spodziewany efekt i pozwól statystyce zrobić robotę. - Zbyt wczesne kończenie testu (lub ciągnięcie go w nieskończoność)

Pułapka: Widzisz zielone +17% w drugim dniu i krzyczysz „Zwycięzca!”

Albo odwrotnie - ciągniesz test miesiąc, bo „może jeszcze urośnie”.

Dlaczego to problem:

Zbyt wczesne zakończenie = fałszywie pozytywne wyniki.

Zbyt długie = masa zewnętrznych czynników zaczyna mieszać Ci w danych.

Jak tego uniknąć:

Ustal minimalny czas trwania testu zanim go uruchomisz.

Obserwuj istotność statystyczną, ale nie bądź jej niewolnikiem. - Ignorowanie segmentów użytkowników

Pułapka: Zakładasz, że wszyscy użytkownicy są tacy sami — czy to nowi, czy powracający, mobilni czy desktopowi.

Dlaczego to problem: Różne segmenty zachowują się różnie.

To, co działa dla użytkowników mobilnych, może totalnie nie działać na desktopie.

Jak tego uniknąć:

Segmentuj wyniki.

Oddziel nowych od powracających, mobile od desktopu, PL od EN.

Może się okazać, że Twój „zwycięzca” działa tylko dla jednej grupy, a reszcie szkodzi. - Mylenie istotności statystycznej z istotnością biznesową

Pułapka: „Mamy statystycznie istotny wzrost… o 0,3%!”

I już wszyscy biją brawo.

Dlaczego to problem: Statystyczna istotność nie oznacza, że wynik cokolwiek zmienia.

Możesz mieć istotny wzrost, który jest… bez znaczenia dla przychodów.

Jak tego uniknąć:

Zadaj sobie pytanie:

„Czy ta zmiana robi różnicę, która ma znaczenie dla biznesu?”

Jeśli nie — olej to i testuj dalej. - Patrzenie tylko na jeden wskaźnik

Pułapka: Testujesz tylko konwersję, nie patrząc na nic innego.

Dlaczego to problem: Możesz poprawić konwersję… kosztem np. wzrostu zwrotów, spadku retencji albo większej liczby porzuconych koszyków w drugim kroku.

Jak tego uniknąć:

Śledź dodatkowe KPI: zaangażowanie, czas na stronie, przychód, retencję.

Optymalizacja jednego wskaźnika kosztem całego biznesu to klasyk początkujących. - Zewnętrzne czynniki rozwalają Ci test

Pułapka: Uruchamiasz test w Black Friday, gdy akurat zmieniasz ceny, a marketing odpala nową kampanię.

Dlaczego to problem: Dane robią się bezużyteczne, bo nie wiesz, co wpłynęło na wynik — test czy kody rabatowe, pogoda, reklama, sezon albo aktualizacja produktu.

Jak tego uniknąć:

Izoluj testy od dużych zmian.

Unikaj sezonowości.

Nie mieszaj testów z kampaniami, które mogą wykrzywić dane. - Brak analizy po zakończeniu testu

Pułapka: Test skończony, jest zwycięzca — wdrażamy!

A analiza? „A po co?”

Dlaczego to problem:

Bez analizy możesz przeoczyć: efekty uboczne, nieoczywiste trendy, zachowania, które wymagają kolejnego testu i segmenty, które zareagowały inaczej.

Jak tego uniknąć:

Zawsze rób sekcję zwłok testów, sprawdź wszystkie metryki, przejrzyj sesje użytkowników, zobacz anomalie.

Wszystko to kupa pracy, więc ponownie warto się zastanowić kiedy testowanie A/B ma sens w kontrze do innych metod, które będą tańsze a okażą się bardziej miarodajne.

Kiedy nie przeprowadzać testów A/B i co robić w zamian?

Jak już wspomniałem wyżej, przy małej ilości danych testy te spowodują duże błędy statystyczne co zaś może spowodować fałszywe pozytywy.

Czyli: w dłuższej perspektywie czasu decyzja o zamianie tej jednej rzeczy na stronie okaże się błędna i być może bardzo kosztowna, zostanie w oklaskach okrzyknięta sukcesem ale w dalszym czasie zignorowana.

Co więc począć i jak sobie radzić kiedy po prostu nie ma jak testować bo nie ma ruchu?

Testowanie przez użytkowników i zbieranie danych.

Jest to metoda kiedy testujesz zachowanie użytkowników przez nagranie ich sesji online, a następnie ich analiza.

Możesz wtedy wyłapać wzorce, które nie są dostępne przez zwykłe testy A/B lub nie wpadniesz na nie tak o jak np. fałszywe dno, o którym pisałem trochę w artykule Użyteczność strony internetowej jak tego nie robić.

Inną opcją jest testowanie przy prawdziwych ludziach czyli wówczas kiedy masz możliwość oglądać na żywo jak osoby korzystają z Twojej strony www bądź aplikacji internetowej.

Minusy testów A/B.

Tak jak ciężko jest pogodzić sytuację, w której jesteś z dwiema siostrami, tak testy A/B też mają swoje wady. Poza tym, że trzeba przeprowadzić dobrze etap przygotowania, to nie uchronią one nas przed kolejnymi problemami którymi są…

Testowanie jednej zmiennej brak widoku na całość

Jedną z nich przez to, że testujesz tylko jedną zmienną ciężko jest ją skorelować z innymi zmiennymi, które mogłeś testować.

Czyli zmieniliśmy napis na inny na przycisku i w testach wyszło nam, że napis “chcę kupić ten złoty …” jest o wiele bardziej konwertujący niż “kupuj to natychmiast bo inaczej…”.

Nie da nam to jednak informacji, która wersja lepiej się sprawdzi z nagłówkiem numer 1 lub 2, który też testujemy przez testy A/B.

Duża ilość porażek

Przygotuj się na to, że większość testów może okazać się porażką i mając na myśli większość są to liczby czasami w 90%, co pewnie spowoduje frustrację i chęć porzucenia tej metody.

Potwierdza to ekspert od testowania Ron Kohavi (Amazon, AriBnb, Microsoft) przy testowaniu często osiągali liczby w górę od 66% testów, które zakończyły się niepowodzeniem.

Test pokory i schowania ego do kieszeni

Twój projektant spędził miesiąc nad nową grafiką, która ma się pojawić zamiast starej i zachęcić do skorzystania z oferty tylko po to, aby po przeprowadzeniu testu okazało się, że jednak stara wersja działa skuteczniej.

Kiedy test może Cię zwolnić z pracy: na co zwracać uwagę przy odczytywaniu wyników.

Zanim zaczniesz ślepo ufać „zielonym wynikom” z Optimizely, VWO czy dowolnego innego narzędzia, przytoczę Ci historię, historię obrazującą co i jak, która wydarzyła się naprawdę.

W przytoczonym przez autora teście wariant A był identyczny z wariantem B. Narzędzie do testowania pokazało:

„Wynik: +18,1% wzrostu!

Prawdopodobieństwo tego że wynik jest prawidłowy: 100%!”

Tak, tak narzędzie ogłosiło zwycięstwo… wersji, która była 1:1.

To świetny dowód na to, że testy A/B potrafią działać jak horoskopy: czasem trafiają, ale nie budowałbym na nich kariery zawodowej.

Dlatego kilka rzeczy musisz wiedzieć, zanim dasz się uwieść magicznym zielonym cyferkom:

- Fałszywe zwycięstwa (false positives) istnieją i są podstępne

Jeśli test pokazuje wynik „zbyt dobry, by był prawdziwy”, to… prawdopodobnie taki właśnie jest.

Przy małym ruchu i źle dobranych parametrach statystycznych możesz wylosować zwycięzcę jak totolotka. - Test jednostronny kontra dwustronny ta różnica ma znaczenie

Wiele narzędzi używa testów jednostronnych, które szybciej dają „pozytywny” wynik.

Problem? Mogą nie wykazać, że Twój wariant jest… gorszy.

A to trochę jak sprawdzać hamulce w samochodzie tylko jadąc z górki. - Piękne wyniki ≠ realny biznes

W artykule autor miał testy z „+60% wzrostu”, „+30% CTR”…

A liczba aktywnych użytkowników? Zero zmian.

To klasyczna pułapka: patrzysz na metryki próżności, ignorując KPI, które faktycznie mają znaczenie. - Narzędzie nie zwalnia z myślenia

Optimizely, VWO i cała reszta to tylko kalkulatory. Mogą pomóc, ale nie mogą podejmować decyzji za Ciebie.

Jeśli nie rozumiesz statystyki, łatwo wpakować się w test, który wygląda profesjonalnie, a jest kompletną katastrofą eksperymentalną.

Jeśli ten artykuł nastraszył cię wystarczająco mocno to przejdźmy teraz do sekcji...

Proces testu A/B krok po kroku.

- Znajdź problem

opieraj się na danych, nie przeczuciach. - Postaw hipotezę

„Zmiana X wpłynie na Y, bo Z”. - Stwórz wariant B

tylko jedna zmiana naraz. - Ustal wskaźnik efektywności i czas trwania

zanim zaczniesz testować. - Uruchom test i nic nie ruszaj

żadnych poprawek w trakcie. - Czekaj na pełne dane

nie kończ po 2 dniach. - Przeanalizuj wyniki

również segmenty. - Wdróż zwycięzcę i monitoruj

kolejne 7-14 dni aby zweryfikować czy na pewno masz dobrze wykonany test.

Co robić po zakończeniu testu A/B?

- Monitoruj KPI po wdrożeniu – test≠produkcja, mogą być różnice.

- Sprawdź inne metryki – retencja, porzucenia, wartość koszyka.

- Przeanalizuj segmenty – mobile ≠ desktop, nowi ≠ powracający.

- Zapisz wnioski – twórz „repozytorium testów”.

- Zaplanuj kolejny test – testy A/B to proces, nie jednorazówka.

Testy A/B vs testy jakościowe

Testy A/B, używaj, gdy:

- masz stabilny ruch,

- chcesz zmierzyć co działa najlepiej,

- decyzja wpływa na przychód.

Testy jakościowe, używaj, gdy:

- ruch jest mały,

- chcesz zrozumieć dlaczego coś działa (lub nie),

- chcesz wykryć błędy UX (np. „fałszywe dno”).

FAQ

Czy testy A/B mają sens, jeśli mam mało ruchu na stronie?

Tak, ale ostrożnie. Przy małym ruchu ryzyko fałszywych wyników rośnie jak temperatura na czarnym serwerze w piwnicy. W takiej sytuacji lepiej skupić się na testach jakościowych (nagrania sesji, heatmapy) albo na dużych zmianach, które mogą faktycznie dać mierzalny efekt.

Ile powinien trwać test A/B?

Na pewno nie trzy dni i nie „dopóki nie zobaczę zielonych cyferek”. Czas zależy od ruchu, ale najczęściej testy powinny trwać od 1 do kilku tygodni, aż osiągniesz sensowną próbę i istotność statystyczną. Kończenie testu przedwcześnie to najlepszy sposób, żeby podjąć złą decyzję z pełnym przekonaniem.

Czy test A/B pokaże mi, dlaczego jakaś wersja działa lepiej?

Nie. Testy A/B mówią co wygrywa – nie dlaczego. Jeśli chcesz zrozumieć przyczynę, potrzebujesz testów jakościowych, obserwacji użytkowników i analizy zachowań. A/B test to narzędzie, nie wróżka z fusami.